站內(nèi)SEO優(yōu)化設(shè)置技巧分享

來(lái)源: http://www.44455ee.com | 時(shí)間:2019.04.22 | 瀏覽數(shù):127

robots.txt文件是一個(gè)文本文件,使用任何一個(gè)常見(jiàn)的文本編輯器,比如Windows系統(tǒng)自帶的Notepad,就可以創(chuàng)建和編輯它 。robots.txt是一個(gè)協(xié)議,而不是一個(gè)命令。robots.txt是搜索引擎中訪問(wèn)網(wǎng)站的時(shí)候要查看的第一個(gè)文件。robots.txt文件告訴蜘蛛程序在服務(wù)器上什么文件是可以被查看的。

一:學(xué)習(xí)robots文件編寫,前提是得熟悉網(wǎng)站url和Url的原理以及網(wǎng)站程序目錄。為什么?很簡(jiǎn)單蜘蛛是通過(guò)url抓取的。文件具體形式,以阿里云主機(jī)根目錄為例,格式表示如下:

技巧:域名=根目錄。

/htdocs/=域名

/htdocs/skin/=域名/skin/

/htdocs/skin/css/=域名/skin/stivle.css/

二:robots寫法注意點(diǎn):冒號(hào)后面有一個(gè)空格 , 必須全英文模式書寫,字母大小寫要注意,這是比較嚴(yán)謹(jǐn)?shù)模枰貏e注意。例如

Disallow: /ab/abc/

Allow: /ab/abc/

User-agent: Baiduspider

三:操作流程以及寫法:桌面新建一個(gè).txt文件,在文件上寫robots規(guī)則。

1:下面先來(lái)看看名詞定義解釋,不同的搜索引擎有不同的蜘蛛。

【1】:User-Agent: 對(duì)蜘蛛進(jìn)行的規(guī)定(1)對(duì)百度蜘蛛的規(guī)定User-agent: Baiduspider 。(2)谷歌User-Agent: Googlebot (3)必應(yīng)User-agent: Bingbot (4)360 User-Agent: 360Spider (5)宜搜User-Agent: Yisouspider(6)搜狗User-Agent: Sogouspider (7)雅虎User-Agent: Yahoo! Slurp

User-Agent: * 指對(duì)所有的蜘蛛

【2】:Disallow: 指禁止抓取。

【3】:Allow: 指允許抓取 。

2:寫法:以上三個(gè)格式綜合使用,例如:我們要屏蔽/skin/文件夾里面的一部分文件,但是又希望抓取到/skin/文件夾里面的/css/文件夾,書寫技巧:先禁止抓取/skin/文件夾,后面再允許抓取/css/ 文件夾就可以了。

Disallow: /skin/ 表示禁止抓取/skin/文件夾

Allow: /css/表示允許抓取/skin/文件夾里面的/css/文件夾

注意點(diǎn):前后都有斜杠表示文件夾。

3:符號(hào)名詞解釋:

(1)*通配符 : 代表所有的 。 例如:

User-Agent: * 就是表示對(duì)所有的蜘蛛

Allow: /skin/* 表示允許包括/skin/文件夾以下的所以文件

(2)$終止符: 表示結(jié)束。例如不允許抓取.js結(jié)尾的文件,寫成: Disallow: /*.js$

四:常見(jiàn)屏蔽對(duì)象:

1:中文的鏈接-路徑,抓取不友好,或者我們不需要它來(lái)排名。例如屏蔽“聯(lián)系我們”:Disallow: /lianxi/

2:搜索結(jié)果頁(yè)面,重復(fù)的質(zhì)量低的。例如:

https://www.shiguangkey.com/course/search?key=%E5%BB%BA%E7%AD%91&cateKey=%E5%BB%BA%E7%AD%91

https://www.shiguangkey.com/course/search?key=%E4%BD%A0%E5%A5%BD&cateKey=%E4%BD%A0%E5%A5%BD

技巧:先找到規(guī)律。假如我們不允許抓取以下的 ,寫成: Disallow: /course/search?key=*

3:動(dòng)態(tài)路徑,鏈接規(guī)律:?%/ ?等等 例如屏蔽帶有?號(hào)的動(dòng)態(tài)鏈接: Disallow: /*?*

4:js文件的 Disallow: /*.js$ 備注:官方的說(shuō)法,關(guān)于js使用建議

5:網(wǎng)站的目錄:模板目錄、插件目錄、后臺(tái)目錄。。。。。。

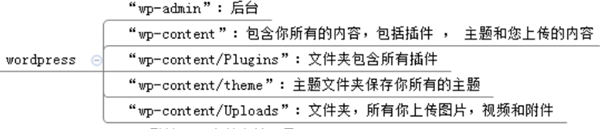

(1):wordpress:如圖

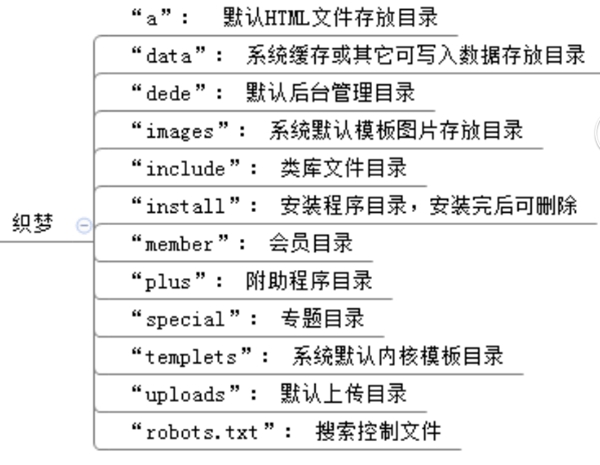

(2)織夢(mèng)程序的。如圖:

五:編寫誤區(qū):

區(qū)別性:例如

Disallow: /ab=Disallow: /ab*

Disallow: /ab/ 前后有斜杠的/ab/代表單個(gè)文件夾

Disallow: /ab = Disallow: /* 斜杠代表了整個(gè)網(wǎng)站,范圍更廣。

例:

Disallow: /ab 這個(gè)規(guī)則對(duì)于以下兩個(gè)鏈接都是屏蔽的:Disallow: /abc Disallow: /ab/123

Disallow: /ab/ 這個(gè)規(guī)則,只對(duì) Disallow: /ab/123 生效,對(duì)于Disallow: /abc是無(wú)效的。

六:網(wǎng)站安全:Disallow: /dede 就知道網(wǎng)站是織夢(mèng)做的,就會(huì)暴露網(wǎng)站程序。

1:織夢(mèng)后臺(tái)是可以修改程序的,例:Disallow: /dede 把dede改成ffff 即:Disallow: /ffff

2:wordpress 呢, 例: Disallow: /wp_admin 修改成:Disallow: /*admin

七:檢測(cè):寫完robots文件后,記得檢測(cè)一下文件。我們可以到百度站長(zhǎng)平臺(tái)校驗(yàn),地址是:http://ziyuan.baidu.com/robots

八:由于蜘蛛首先抓取的是robots文件,所以我們需要把我們網(wǎng)站地圖【網(wǎng)站鏈接集成】寫入到robots文件里面,可以放在文件最底部,方便蜘蛛更快抓取和更好收 錄。

總之robots.txt文件是個(gè)比較嚴(yán)謹(jǐn),書寫過(guò)程嚴(yán)格按照規(guī)則來(lái),當(dāng)然最重要的是寫好之后要檢查,以防書寫錯(cuò)誤,導(dǎo)致蜘蛛抓取不到。